在迈向AGI(通用人工智能)的持续探索中,国内大模型领军企业智谱再次突破了开源模型的能力边界。

9月30日,智谱正式发布并开源新一代大模型GLM-4.6,在Agentic Coding等核心能力上实现大幅跃升。国庆节前,这是继DeepSeek-V3.2-Exp与Claude Sonnet 4.5之后的行业内又一重大技术发布。

目前,GLM-4.6已上线智谱MaaS平台bigmodel.cn,即将在Hugging Face、ModelScope同步开源,并遵循MIT协议。

代码能力全面进阶

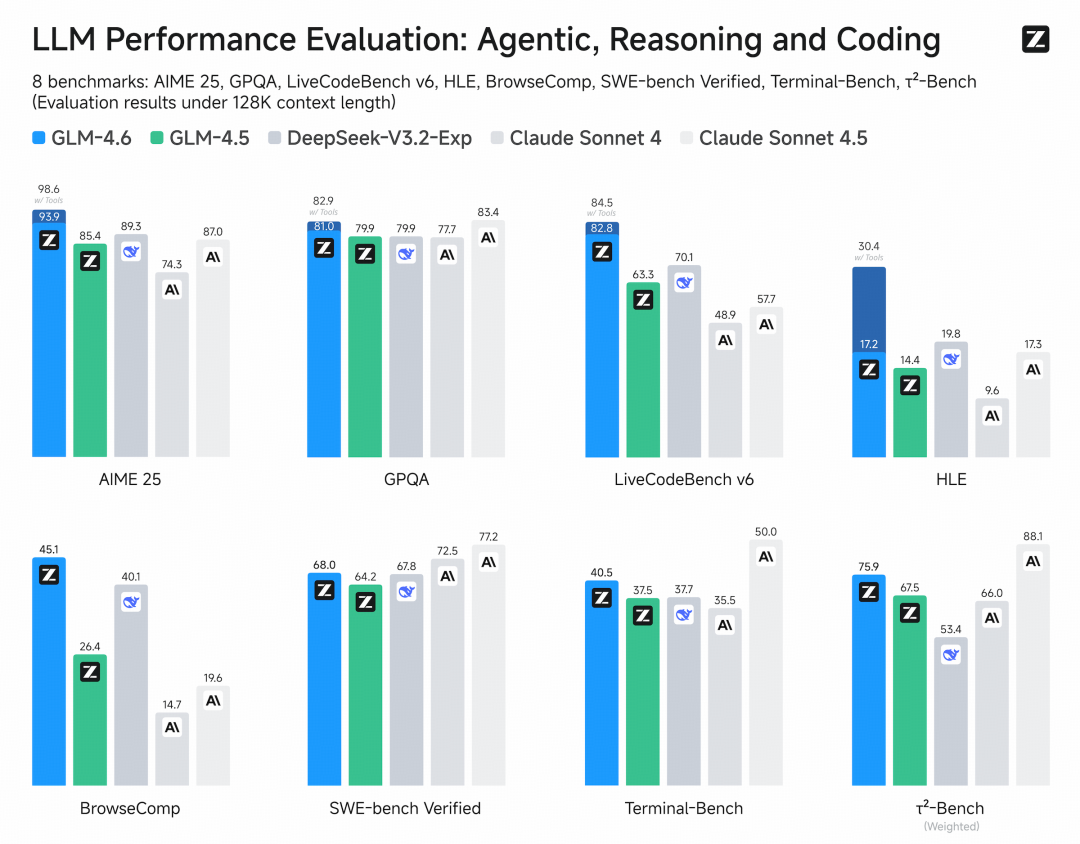

记者注意到,在公开基准测试和真实编程任务中,GLM-4.6的代码生成能力已全面对齐Claude Sonnet 4,成为目前国内最强的Coding模型。

智谱供图

同时,模型在长上下文处理、推理能力、信息检索、文本生成及智能体应用等方面均实现全面升级,整体性能超越DeepSeek-V3.2-Exp。

作为开源模型,GLM-4.6目前是全球开源生态中性能最强的通用大模型之一,进一步提升了国产大模型在全球竞争格局中的地位。

为了测试模型在实际编程任务中的能力,智谱在ClaudeCode环境下进行了74个真实场景编程任务测试。结果显示,GLM-4.6实测超过Claude Sonnet 4,超越其他国产模型。在平均token消耗上,GLM-4.6比GLM-4.5节省30%以上,为同类模型最低。记者了解到,为确保透明性与可信度,智谱已公开全部测试题目与Agent轨迹,供业界验证与复现。

此前,GLM-4.6的上一代模型GLM-4.5首次在单个模型中实现将推理、编码和智能体能力原生融合。GLM-4.5在代码能力上的突出表现让其取得一些成绩,在Openrouter上稳居全球前十供应商,自发布后智谱MaaS平台API商业化同比实现10倍以上增长。

寒武纪、摩尔线程完成对GLM-4.6的适配

智谱官方宣布,GLM-4.6已在寒武纪领先的国产AI芯片上实现FP8+Int4混合量化推理部署,这也是首次在国产芯片上投产的FP8+Int4模型-芯片一体化解决方案。在保持模型精度不变的前提下,该方案大幅降低了推理成本,为国产芯片本地化运行大模型提供了可行路径和示范意义。

与此同时,摩尔线程基于vLLM推理框架完成了对GLM-4.6的适配,新一代GPU可在原生FP8精度下稳定运行模型,充分验证了MUSA架构及全功能GPU在生态兼容性和快速适配能力方面的优势。

寒武纪与摩尔线程完成对GLM-4.6的适配,标志着国产GPU已具备与前沿大模型协同迭代的能力,加速构建自主可控的AI技术生态。GLM-4.6搭配国产芯片的组合将率先通过智谱MaaS平台面向企业与公众提供服务,释放更广泛的社会与产业价值。

未来,国产原创的GLM系列大模型与国产芯片的深度协同,将在模型训练和推理环节持续推动性能与效率的双重优化,构建更加开放、可控、高效的人工智能基础设施。