近日,上海交通大学长聘教授、通用人工智能研究所所长赵海收到两个好消息:一是他带领团队研发的“脑启发大语言模型”入选了“交大2030”计划B类,获得500万元经费支持;二是他的研究方向列入了上海市科委“类脑智能”项目申报指南,这份指南设立“颠覆性技术研究”专题,支持科学家探索脑启发类脑智能的新原理和新方法,研究新型非Transformer架构的类脑大模型通用架构。

Transformer是谷歌在2017年提出的一种深度学习架构,此后经OpenAI持续开发,彻底改变了自然语言处理、计算机视觉等领域的技术格局,成为人工智能大模型普遍采用的架构。那么,上海为何要布局颠覆这种架构的科技项目?类脑大模型的研发进展如何?记者在采访中了解到值得关注的阶段性成果。

从脑科学成果中获得灵感

ChatGPT风靡全球后不久,就有一些人工智能知名专家质疑Transformer架构的发展潜力。比如,图灵奖得主杨立昆认为,这种架构面临计算成本高、缺乏对复杂世界的理解、决策过程“黑箱化”等瓶颈,未来无法实现科学家梦寐以求的通用人工智能——智能体具有高效的学习和泛化能力,能根据所处的复杂环境自主提出并完成任务,且符合人类伦理规范。

今年1月,诺贝尔化学奖得主哈萨比斯谈及通用人工智能时说:“也许我们还需要1—2个类似Transformer的突破。”这意味着,Transformer很可能不是大模型架构的最终方案,在探索通用人工智能的道路上,还需要有大的创新突破。

Transformer很可能不是实现通用人工智能(AGI)的最终方案。

模拟人脑,是创新大模型架构的一条路径,因为作为大自然进化的产物,人脑就是一种通用人工智能体。“2016年,加州大学伯克利分校团队在《自然》杂志发表了一篇论文,他们发现,大脑皮层的不同区域可编码特定的语义内容。”赵海向记者介绍了这项脑科学成果。大模型架构可否模拟大脑的语义编码机制?2023年9月,这位交大教授有了创新灵感,打算颠覆Transformer架构,研发一种“脑启发大语言模型”。

于是,他自筹科研经费,租借GPU服务器,带领团队走进了类脑智能领域的“无人区”。当时,用于训练大模型的GPU服务器处于价格高位,赵海团队每月要花18万元租金。至于研发能否成功,完全是个未知数。面对双重压力,他选择了坚持,因为他相信:通用人工智能的真正基石隐藏在人类大脑中。

新范式模拟人脑全局机制

今年3月,150亿参数的“脑启发大语言模型”(BriLLM)问世,交大团队开源发布了这个中文大模型的代码和模型权重。5月,他们发布了“脑启发大语言模型”中文、英文压缩版,其大小分别为20亿和10亿参数,但性能与150亿参数大模型相当。测试显示,这3个非Transformer架构类脑大模型的生成能力达到GPT-1水平,引起了华为公司Fellow蔡华等专家的关注。

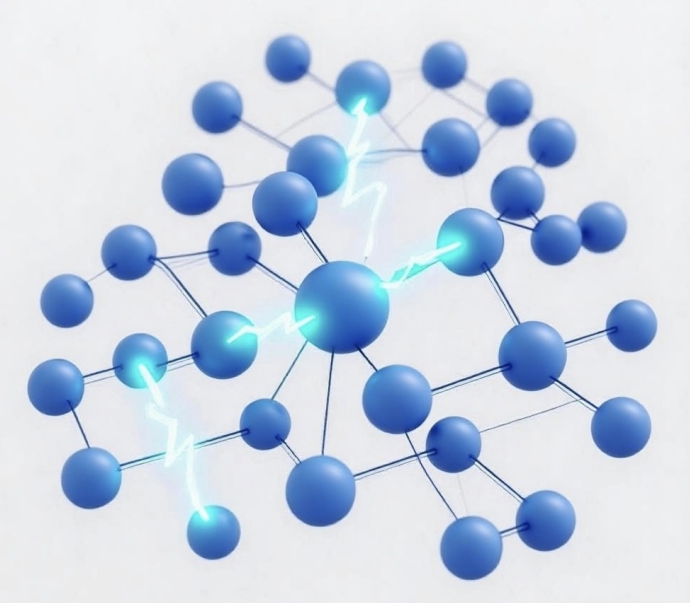

“BriLLM是首个在宏观尺度上模拟人脑全局机制的大语言模型,对机器学习范式做了颠覆性创新。”赵海介绍,它采用“信号全连接流动”机制,以取代Transformer架构的自注意力机制。这种新的机器学习范式模拟大脑皮层编码特定语义的方式,将词元(token)直接映射为“有向全连接图”模型架构上的一个个节点,让每个节点对应一个语义单元。它还模拟脑电波的传播方式,让信号沿着“最小阻力”路径,在“有向全连接图”上不断传播,选择性地激活一些语义单元节点,使大模型生成准确的文字内容。

“信号全连接流动”机制示意图

与Transformer架构大模型相比,“脑启发大语言模型”有四大潜在优势:通过模拟人脑的语义编码和信号传播机制,获得人脑的低能耗优势,大模型计算成本有望大幅降低;每个节点都对应明确语义,决策过程透明可解释,消除了大模型决策的“黑箱”问题,有利于确保人工智能安全可控;由于信号可在各个节点间无限制传播,它有望支持无限长的上下文输入,且无须增加模型规模;与多模态天然适配,在学习图像和视频时更接近人类学习方式,不依赖大数据。

凭借这些优势,赵海团队经过4轮评审,获得了“交大2030”计划B类立项支持。B类项目倡导“从 0 到 1”的原始创新,瞄准世界级基础科学问题。它不设论文指标,允许项目团队在科研领域自由使用经费。“我们打算把500万元主要用于购买算力,未来两年开发出像ChatGPT那样的对话式大模型,与Transformer架构大模型展开竞争。”得到项目支持后,赵海对这一颠覆性创新的前景更有信心了。

瞄准百亿参数大模型目标

在类脑大模型这一前沿领域,赵海并不是独行者。记者从中国科学院脑智卓越中心了解到,脑认知与类脑智能全国重点实验室研究员李国齐在研发“类脑通用智能大模型”。他的技术路线与赵海不同,主要在微观尺度上模拟大脑神经元的激活方式。

李国齐认为,Transformer架构大模型的基础是“点神经元模型+自注意力机制”,而人脑的基本计算单位是树突神经元模型。它比点神经元模型复杂得多,呈树状结构,包含多个分支和房室,每个分支和房室都存在不同参数的动力学过程,使树突神经元模型拥有多尺度的记忆能力。“我们的目标是研究可否将这种人脑机制融入现有大模型,构建一个通用的类脑智能大模型架构。”

为此,他带领团队开展了一系列探索:在理论层面,发表了关于脉冲神经网络训练算法的多篇论文,将脉冲神经网络从过去的5—10层拓展到50—500层;在神经元模型层面,提出了多房室、多分支的并行脉冲神经元模型,在解决长序列建模问题上取得进展;在架构层面,提出了“树突脉冲神经网络”这个概念,将源自人脑的神经元模型纳入机器学习框架。

谈及未来研发计划,李国齐说:“我们希望通过跨学科合作,推动算法、训练平台和芯片的深度整合,构建百亿至千亿参数规模的通用类脑大模型。”

赵海也打算开发百亿参数规模的类脑大模型。未来两年,他将带领团队完成中文和英文预训练、指令微调能力构建、高效推理部署三项任务,开发出规模不低于300亿参数的中文和英文“脑启发大语言模型”,让用户体验到非Transformer架构大模型的优势。

“我们团队已走通‘从0到1’的原始创新,接下来要做的是‘从1到10’的升级突破。希望得到政府部门更多的算力支持,让我们加快迭代类脑大模型。”赵海说。