刚刚,DeepSeek放大招!

今日,DeepSeek宣布,官方App、网页端、小程序均已同步更新为DeepSeek-V3.2-Exp。DeepSeek介绍,得益于新模型服务成本的大幅降低,官方API价格也相应下调,新价格即刻生效。在新的价格政策下,开发者调用DeepSeek API的成本将降低50%以上。

在DeepSeek-V3.2发布前夕,有消息称,智谱新模型GLM-4.6也将于近日发布,目前已可通过API接口调用。在Z.ai官网可以看到,GLM-4.5已被标识为上一代旗舰模型。

DeepSeek-V3.2-Exp发布

9月29日,DeepSeek-V3.2-Exp模型正式在Hugging Face平台发布并开源。

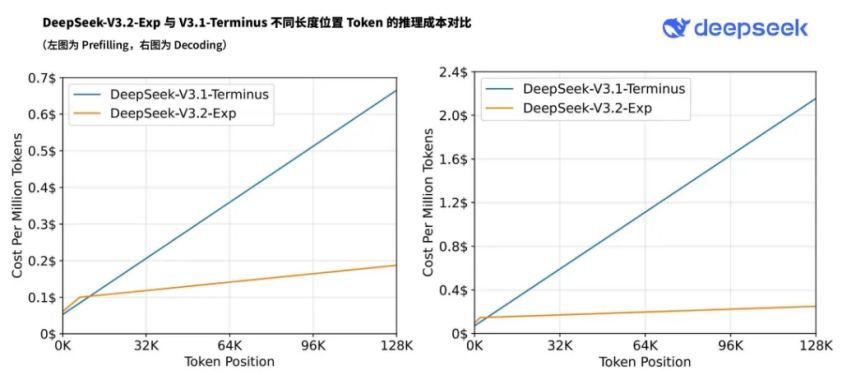

该版本作为迈向下一代架构的重要中间步骤,在 V3.1-Terminus 的基础上引入了团队自研的 DeepSeek Sparse Attention (DSA) 稀疏注意力机制,旨在对长文本的训练和推理效率进行探索性优化与验证。这种架构能够降低计算资源消耗并提升模型推理效率。

目前,华为云已完成对DeepSeek-V3.2-Exp模型的适配工作,最大可支持160K长序列上下文长度。

寒武纪也在官方公众号同步称,公司已同步实现对深度求索公司最新模型DeepSeek-V3.2-Exp的适配,并开源大模型推理引擎vLLM-MLU源代码。开发者可以在寒武纪软硬件平台上第一时间体验DeepSeek-V3.2-Exp的亮点。

DeepSeek宣布官方App、网页端、小程序均已同步更新为DeepSeek-V3.2-Exp。

DeepSeek Sparse Attention(DSA)首次实现了细粒度稀疏注意力机制。DeepSeek方面表示,这项技术在几乎不影响模型输出效果的前提下,大幅提升了长文本场景下的训练和推理效率。

为了确保评估的严谨性,DeepSeek-V3.2-Exp 的训练设置与前代 V3.1-Terminus 进行了严格对齐。测试结果显示,该模型在各大公开评测集上的表现与 V3.1-Terminus 基本持平,有效性得到了初步验证。

DeepSeek宣布,得益于新模型服务成本的大幅降低,官方API价格也相应下调,新价格即刻生效。

在新的价格政策下,输入方面,缓存命中时价格为0.2元/百万tokens,缓存未命中时价格为2元/百万tokens,输出方面则为3元/百万tokens,开发者调用DeepSeek API的成本将降低50%以上。

DeepSeek现已将DeepSeek-V3.2-Exp模型在 Huggingface 和 ModelScope 平台上全面开源,相关论文也已同步公开。

作为一款实验性版本,DeepSeek认识到模型仍需在更广泛的用户真实场景中进行大规模测试。为便于开发者进行效果对比,DeepSeek为V3.1-Terminus 版本临时保留了 API 访问接口,且调用价格与 V3.2-Exp 保持一致。该对比接口将保留至北京时间2025年10月15日23:59。

此外,为支持社区研究,DeepSeek还开源了新模型研究中设计和实现的GPU算子,包括 TileLang和CUDA 两种版本。团队建议社区在进行研究性实验时,优先使用基于TileLang的版本,以便于调试和快速迭代。

值得一提的是,DeepSeek似乎有在节前发布新版本或更新的惯例。

回顾此前,2024年12月27日,也就是元旦前DeepSeek发布了 DeepSeek V3。

2025年5月28日,其在端午节前发布了 DeepSeek-R1-0528,官方称其为端午节特别献礼。

DeepSeek最新一次更新则是在一周前的9月22日,DeepSeek在其官方API平台发布了DeepSeek-V3.1-Terminus模型,并宣布模型开源,同时公布了开源版本下载地址。

智谱GLM-4.6即将发布

在DeepSeek-V3.2发布前夕,有消息称,智谱GLM-4.6也即将发布,官方也在微信群提示,GLM-4.6即将带来更大的上下文。

目前在智谱Z.ai官网上,其主力模型GLM-4.5已被标识为“上一代旗舰模型”。

据悉,GLM-4.5V基于智谱新一代旗舰文本基座模型GLM-4.5-Air,延续GLM-4.1V-Thinking 技术路线,在41个公开视觉多模态榜单中综合效果达到同级别开源模型SOTA性能,涵盖图像、视频、文档理解以及GUI Agent等常见任务。

据介绍,多模态推理被视为通向通用人工智能(AGI)的关键能力之一,让AI能够像人类一样综合感知、理解与决策。其中,视觉-语言模型(Vision-Language Model, VLM)是实现多模态推理的核心基础。

智谱此前表示,GLM-4.5 在前端开发、跨文件修改、全栈项目构建等典型场景中展现出稳定、实用的表现。根据反馈,其解决实际问题的能力已接近 Claude Sonnet 4。在多个开源评测中,GLM-4.5 也与国际主流模型保持同等竞争力:

WebDev Arena:与全球领先模型并列第二;

SWE-bench Verified:性能优于 Gemini-2.5-Pro 和 GPT-4.1;

BFCL v4 基准:全球第一,超过 Claude Opus 4.1,成本仅为其 1.5%。