大模型落地不能只有精英算力路径,更需要一条更广谱、高性价比的路线。

新民晚报记者获悉,趋境科技与清华共同开源的KTransformers,正以异构协同释放本地硬件潜力,以开源能力帮助更多团队和组织用得起、调得动、融得进自己的业务中,逐步实现算力普惠。

据介绍,在月之暗面正式发布Kimi-K2-Thinking模型后,KTransformers已完成对该模型的全面适配,单卡环境可完成推理任务,2卡环境可完成LoRA微调任务,大幅降低部署与定制化门槛。更值得关注的是,趋境科技也已完成了该模型在昇腾NPU上的全面适配,提供了完善的全国产化推理解决方案,为国产硬件生态与大模型落地搭建起高效桥梁。

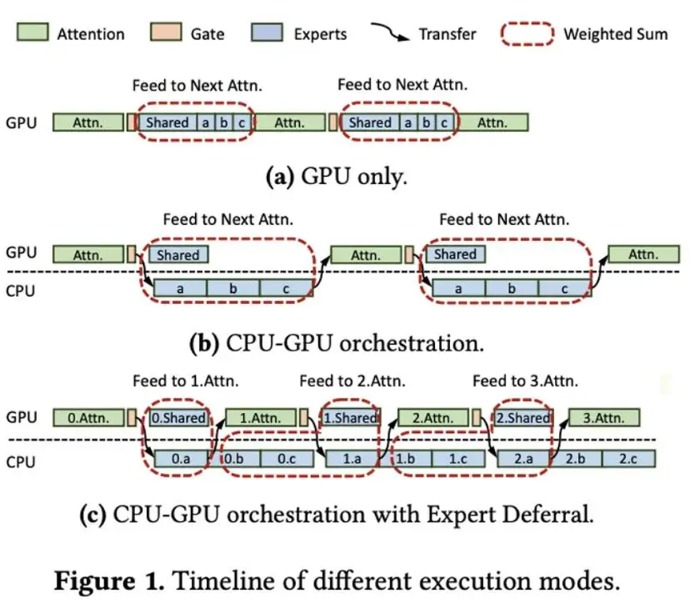

KTransformers是一个高性能异构推理框架,专注于高效利用底层GPU、CPU、内存等多样化算力。在大模型推理中,它提出了面向CPU+GPU异构架构的MoE推理系统方案,通过系统级创新让GPU负责注意力和主干网络的高并行计算,CPU承担稀疏专家模块的推理任务,实现高效协同执行,让原本依赖昂贵多卡GPU的大模型,能在CPU参与的硬件环境中实现接近同等性能的推理体验。

不久前,KTransformers与主流推理框架SGLang达成合作,双方架构合入同一分支。在Kimi-K2-1TB的模型推理任务中,用户仅需简单安装SGLang与KTransformers CPU内核,下载官方模型及量化权重,即可通过一条命令启动服务,且仅需单张消费级GPU+CPU。此次合作推动大模型推理向更高性能、更低成本的方向演进,助力其更广泛的产业落地。

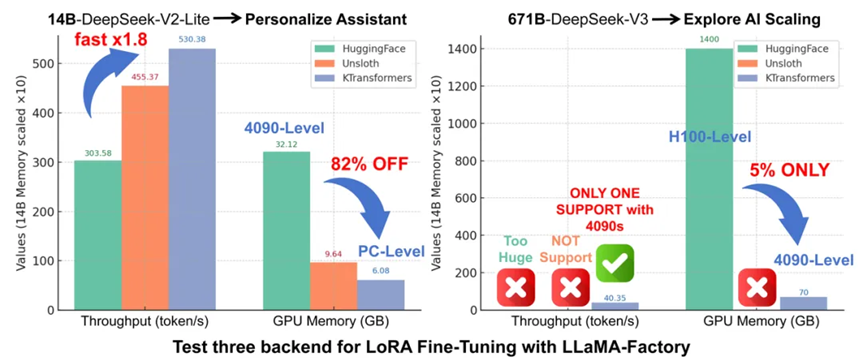

针对模型微调的核心需求,KTransformers与LLaMA-Factory深度集成,支持LoRA等轻量级微调方法,仅占用约41GB显存+2T内存,就能实现46.55 token/s的微调吞吐量。传统上,LoRA微调千亿模型成本高达数百万,而趋境的异构微调能力将资源需求降低到单个消费级GPU(如 RTX 4090)起,这使得高校、中小型实验室、初创公司甚至个人开发者都有机会参与进来。该方案在DeepSeek-14B模型上展现了超过传统方案1.8倍的吞吐、显存占用降低82%,是消费级显卡上微调超大参数MoE模型的唯一可行方案。

如今的KTransformers已成为被开发者、厂商与开源社区广泛复用的共建式底层框架。全球头部开源模型方,如Qwen、Kimi、智谱AI等多个主流大模型,都在模型发布首日就推荐KTransformers作为推理引擎支持;其工程实践与兼容性也被多家一体机产品线采纳。趋境科技已与多个国产CPU、GPU硬件平台合作,为数十家行业开发伙伴提供算力底座。